کلان داده ها حوزه ای هستند که روش های تجزیه و تحلیل، استخراج سیستماتیک اطلاعات، یا در غیر این صورت برخورد با مجموعه داده هایی که بسیار بزرگ یا پیچیده هستند را نمی توان با نرم افزارهای کاربردی سنتی پردازش داده ها مورد بررسی قرار داد.

داده های دارای بسیاری از زمینه ها (ستون ها) قدرت آماری بیشتری طلب می کنند، در حالی که داده های با پیچیدگی بیشتر (ویژگی ها یا ستون های بیشتر) ممکن است منجر به نرخ کشف کاذب بیشتر شود. چالش های تجزیه و تحلیل داده های بزرگ شامل گرفتن داده ها، ذخیره داده ها، تجزیه و تحلیل داده ها، جستجو، اشتراک گذاری، انتقال، تجسم، پرس و جو، به روز رسانی، حفظ حریم خصوصی اطلاعات و منبع داده است.

داده های بزرگ در ابتدا با سه مفهوم کلیدی مرتبط بودند: حجم ، تنوع و سرعت. تجزیه و تحلیل داده های بزرگ چالش هایی را در نمونه گیری ایجاد می کند و بنابراین قبلاً فقط امکان مشاهده و نمونه گیری وجود داشت. بنابراین، داده های بزرگ اغلب شامل داده هایی با اندازه هایی است که از ظرفیت نرم افزارهای سنتی برای پردازش در زمان و ارزش قابل قبول بیشتر است.

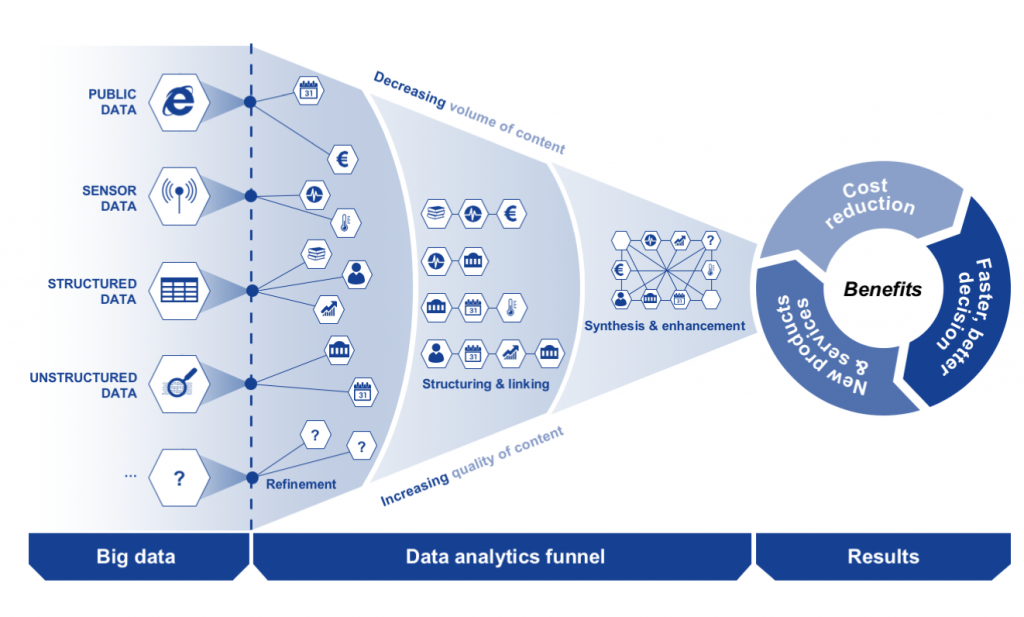

بیگ دیتا یک اصطلاح تکاملی است که حجم زیادی از ساختار، دادههای نیمه ساختار یافته و غیرساختاری را توصیف میکند. این دادهها پتانسیل آن را دارند که برای اطلاعات استخراج شوند و در پروژههای یادگیری ماشین و سایر برنامههای پیشرفته تجزیه و تحلیل استفاده شوند.

مجموعه دادههای بیگ دیتا چنان حجیم است که پردازشگرهای سنتی نمیتوانند آن را تحلیل کنند. اما این اطلاعات، بهترین راهحل برای مشکلات بزرگ تجاری است. مشکلاتی که تا قبل از این حل کردن آنها غیرممکن بوده است.

تجزیه و تحلیل داده های بزرگ استفاده از تکنیک های تحلیلی پیشرفته در برابر مجموعه داده های بزرگ و بسیار بزرگ است که شامل داده های ساختار یافته، نیمه ساختار یافته و بدون ساختار، از منابع مختلف و در اندازه های مختلف از ترابایت تا زتابایت است.

با تجزیه و تحلیل داده های بزرگ، در نهایت می توانید به تصمیم گیری بهتر و سریعتر، مدل سازی و پیش بینی نتایج آینده و افزایش هوش تجاری کمک کنید. همانطور که راه حل داده های بزرگ خود را ایجاد می کنید، نرم افزارهای منبع باز مانند Apache Hadoop ، Apache Spark و کل اکوسیستم Hadoop را به عنوان ابزارهای مقرون به صرفه، پردازش و ذخیره سازی داده های انعطاف پذیر که برای مدیریت حجم داده های تولید شده امروزه طراحی شده اند، در نظر بگیرید.

دادهها تنها در صورتی ارزشمند هستند که از آنها استفاده شود. بسیاری از دادهها به شکلی سازمانیافتهاند که میتوان آنها را بهراحتی تجزیهوتحلیل کرد؛ اما این موضوع در رابطه با همهی دادهها صادق نیست. تجزیهوتحلیل کلان داده، در بسیاری از موارد به زمان و دقت زیادی نیاز دارد. دانشمندان معمولاً بین ۵۰ تا ۸۰ درصد از زمان آنالیز بیگ دیتا را صرف تنظیم و آمادهسازی اطلاعات میکنند. این یعنی دادههای بدون ساختار و آمادهسازی آنها، همچنان یکی از چالش های کلان داده است.

ظرفیت سرانه تکنولوژیکی جهان برای ذخیره اطلاعات از دهه 1980 هر 40 ماه یکبار دو برابر شده است. تا سال 2012، هر روز 2.5 اگزابایت (2.5 × 260 بایت) داده تولید می شود. بر اساس یک پیش بینی گزارش IDC، حجم داده های جهانی پیش بینی می شد بین 4.3 زتابایت به 44 زتابایت بین 2013 تا 2020 برسد. تا سال 2025، IDC پیش بینی می کند که 163 زتابایت داده وجود خواهد داشت. یک سوال برای شرکتهای بزرگ تعیین این است که چه کسانی باید دارای طرحهای کلان داده باشند که بر کل سازمان تأثیر می گذارد.

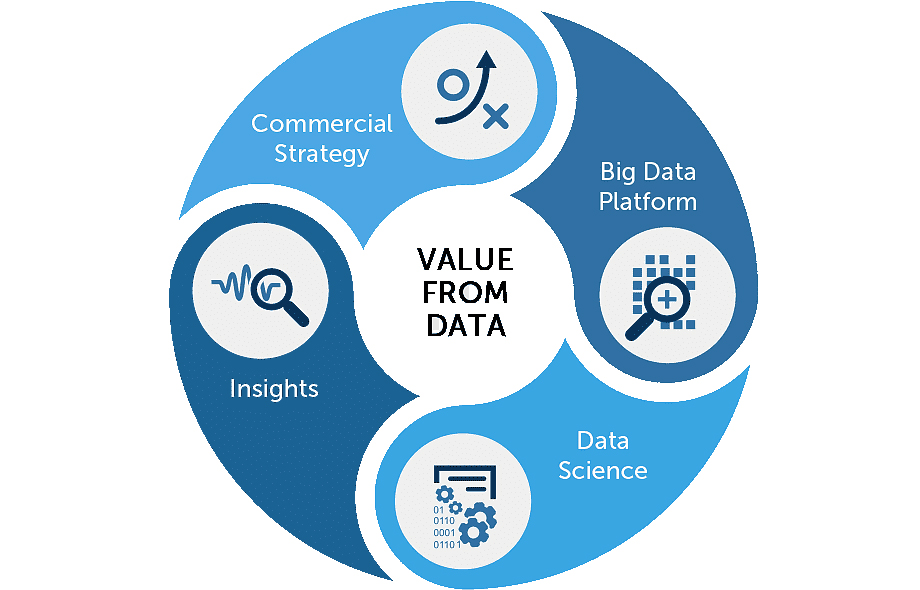

مفهوم کلان داده سالهاست که وجود دارد. اکثر سازمانها اکنون درک کرده اند که اگر تمام داده هایی را که در کسب و کارشان جریان دارد، بدست آورند، می توانند تجزیه و تحلیل را اعمال کرده و از آن ارزش قابل توجهی کسب کنند.

مزایای جدیدی که تجزیه و تحلیل داده های بزرگ روی میز می آورد، سرعت و کارایی است. در حالی که چند سال پیش یک کسب و کار اطلاعاتی را جمع آوری می کرد، تجزیه و تحلیل می کرد و اطلاعاتی را کشف می کرد که می تواند برای تصمیمات آینده استفاده شود، امروزه این تجارت می تواند بینش هایی را برای تصمیمات فوری شناسایی کند. توانایی کار سریعتر- و چابک ماندن – به سازمانها مزیت رقابتی می دهد که قبلاً نداشتند.

یک بیمارستان در کشور سوئد با بهرهمند شدن از بیگ دیتا به شکل مؤثری توانست خیلی از موارد موجود در این بیمارستان را بهبود بدهد. مسئولین و پزشکان این بیمارستان توانستند از طریق بیگ دیتا اطلاعات جامعی در مورد دهها بیماری کسب کنند. این کار باعث شد تا هزینههای اضافی آنها و همچنین بیماران به حداقل برسد.

از طرف دیگر، آنها اطلاعات کاملی داشتند و نیازی برای صرف زمانهای زیاد برای انجام آزمایشهای گوناگون برای خیلی از بیماریها نبود و صرفاً معاینههای معمولی و علائم کمتر توجه شده اطلاعات کاملی از بیماریها برای آنها نمایش میداد. استفاده از کلاندادهها باعث شد تا سرعت پردازش رسیدگی به بیمارها چندین برابر بیشتر شده و همچنین مراحل درمان نیز با سرعت و دقت بیشتری انجام شود.

همه اینها به ما نشان میدهد که تجزیه و تحلیل کلان داده برای ایجاد معنی در حجم عظیم دادهها چیست. تجزیه و تحلیل کلان داده به ما کمک میکند تا دادهها را بر اساس نیازهای سازمان، تغییر شکل داده و مدلسازی کنیم و الگوها را شناسایی کرده و از آن نتیجه بگیریم.